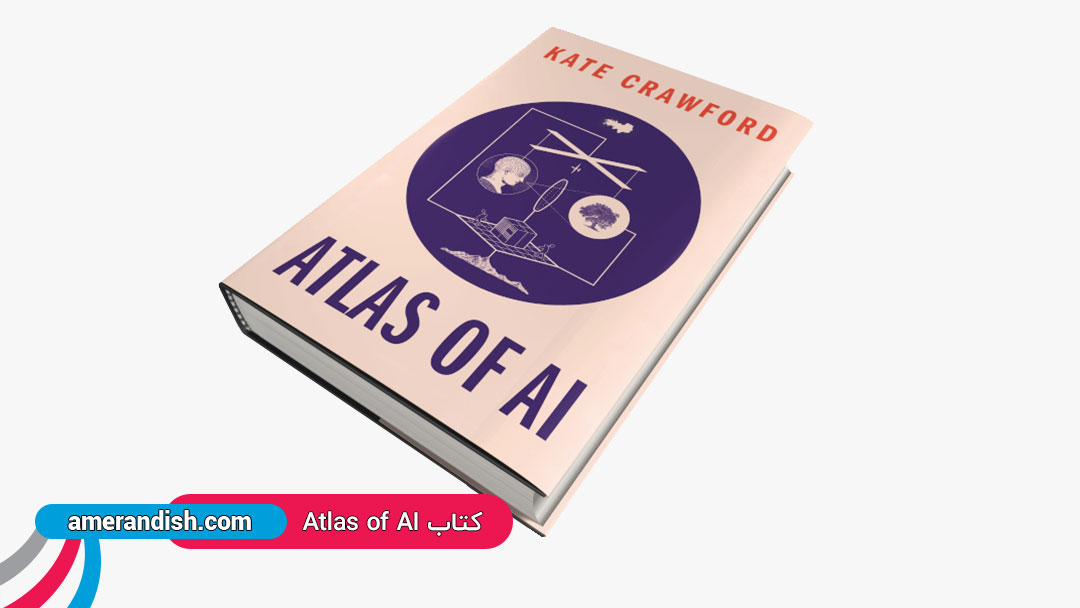

کیت کرافورد، یک شخص صاحب منصب در USC و Microsoft، در کتاب جدید خود گفته است که حتی متخصصانی که روی این فناوری کار میکنند نیز هوش مصنوعی را اشتباه میگیرند. کیت کرافورد میگوید: «هوش مصنوعی منابع طبیعی زیادی را استفاده میکند و بی شباهت به یک معدن لیتیوم نیست.» شرکتهای فنی دوست دارند هوش مصنوعی را به عنوان ابزاری دقیق و قدرتمند برای همیشه به تصویر بکشند. کیت کرافورد میگوید که این طرز فکری درست نیست. وی در کتاب خود به نام Atlas of AI، از یک معدن لیتیوم، یک انبار آمازون و یک بایگانی جمجمه فرنولوژیک (علمی که با استفاده از اندازهگیری جمجمه انسان ویژگیهای شخصیتی، استعدادها و توانایی ذهنی را تعیین میکند) از قرن نوزدهم بازدید میکند تا منابع طبیعی، طبیعت انسان و علم اشتباه موجود در برخی نسخههای این فناوری را نشان دهد. کرافورد، استاد دانشگاه کالیفرنیای جنوبی و پژوهشگر مایکروسافت، میگوید بسیاری از کاربردها و عوارض جانبی هوش مصنوعی نیاز فوری به تنظیم مقررات دارند.

کرافورد اخیراً این مسائل را با تام سیمونیت، نویسنده ارشد WIRED، در میان گذاشته است. کمتر کسی تمام جزئیات فنی هوش مصنوعی را درک میکند. شما استدلال میکنید که برخی از متخصصانی که روی این فناوری کار میکنند، هوش مصنوعی را عمیقتر درک نمیکنند.

کیت کرافورد میگوید: «این روش به عنوان روشی هوشمندانه و عینی برای تصمیم گیری ارائه میشود و میتوانیم آن را در همه موارد، از آموزش به کودکان تا تصمیم گیری برای وثیقه گذاری استفاده کنیم. اما این فریبنده است. هوش مصنوعی نه مصنوعی است و نه باهوش.» کرافورد ادامه داد: « برای ساختن هوش مصنوعی نیاز به استفاده از منابع طبیعی، انرژی و نیروی کار انسانی است و به هیچ وجه از هوش انسانی باهوشتر نیست. هوش مصنوعی بدون آموزش انسانی قادر به تشخیص چیزی نیست و از منطق کاملا متفاوتی برای معنیسازی برخوردار است. از همان ابتدای هوش مصنوعی در سال ۱۹۵۶، ما این خطای وحشتناک را انجام دادهایم. خطای اصلی باور این بود که ذهنها مانند کامپیوتر هستند و برعکس. ما تصور میکنیم که این موارد مشابه هوش انسانی است و چیزی فراتر از این حقیقت نیست.» کیت کرافورد درباره چگونگی ساخت هوش مصنوعی میگوید: «شما با نشان دادن چگونگی ساخت هوش مصنوعی، آن خطای اصلی را تایید میکنید؛ که این هم مانند بسیاری از فرآیندهای صنعتی، اشتباه به نظر میرسد. برخی از سیستمهای یادگیری ماشین با دادههایی که عجولانه جمع آوری شده، ساخته شده که میتواند مشکلاتی داشته باشند. مانند خدمات تشخیص چهره که بخاطر عدم بلوغ، در برخی موارد مستعد خطای زیاد است. ما باید از تمام ظرفیتهای تولیدات هوش مصنوعی استفاده کنیم.»

مشکل اصلی در استفاده از دادهها در دهه 1980 شروع شد؛ زمانی که استفاده از مجموعه دادهها بدون آگاهی دقیق از آنها و یا بدون نگرانی از حفظ حریم خصوصی معمول شد. این دادهها فقط یک ماده خام بود که در هزاران پروژه مورد استفاده قرار میگرفت. این به یک ایدئولوژی استخراج دادههای انبوه تبدیل شده است. دادهها یک ماده بی اثر نیستند بلکه همیشه یک زمینه و سیاست را به همراه دارند. این جملههای آقای ردیت با جملات موجود در کتابهای کودکان متفاوت خواهد بود. تصاویر پایگاههای اطلاعاتی که عکسهایی از افراد برای شناسایی وجود دارد (mugshot) تاریخهای متفاوتی نسبت به اسکار دارند؛ اما همه آنها به طور یکسان مورد استفاده قرار میگیرند که در نهایت موجب اشکالاتی میشود. هنوز هیچ استاندارد گستردهای در سال 2021 در سطح صنعت وجود ندارد که بتواند به انواع دادهها در مجموعههای آموزشی، نحوه به دست آوردن آنها یا مسائل اخلاقی مربوط به آن توجهی داشته باشد. شما ریشههای نرمافزار تشخیص احساسات از روی چهره، تا علوم مشکوکی که بودجه آن را وزارت دفاع در دهه 1960 تأمین کرده است، جستجو کنید در مییابید که طبق بررسیهای اخیر در بیش از 1000 مقاله تحقیقاتی، هیچ دلیل مستند و قابل اعتمادی در مورد تشخیص احساسات فرد از طرق چهره وجود ندارد.

در مقاله دیگر با نام “ارتباط داده کاوی و هوش مصنوعی” به معرفی داده کاوی (به معنای استخراج و کاوش در حجم وسیعی از دادهها) پرداختیم.

تشخیص احساس بیانگر این توهمی است که فناوری سرانجام به سوالاتی که درباره طبیعت انسان داریم که اصلاً سوالات فنی نیز نیستند، پاسخ خواهد داد. این ایده که در زمینه روانشناسی بسیار مورد مناقشه است، باعث جهش به یادگیری ماشینی شد زیرا این یک نظریه ساده است که متناسب با ابزار است. ثبت چهره افراد و مرتبط کردن آن با حالات احساسی ساده و از پیش تعریف شده که با یادگیری ماشینی کار میکند. کرافورد میگوید: «از آنجا که ما ابزارهای تشخیص احساسات داریم ، مردم میگویند ما میخواهیم آن را در مدارس و دادگاهها اعمال کنیم و دزدهای احتمالی مغازهها را بگیریم. اخیراً شرکتها از همهگیری به عنوان بهانهای برای استفاده از تشخیص احساسات در کودکان در مدارس استفاده میکنند. این کار را به گذشته فرنولوژیک برمیگرداند، این باور که شخصیت شما را از صورت و شکل جمجمه تشخیص میدهد.»

پاسخ به سوالات

سیمونیت از کیت کرافورد پرسید که «شما در تحقیقات اخیر در زمینه چگونگی اثرات نامطلوب هوش مصنوعی کمک کردهاید. اما این حوزه درگیر افراد و بودجه صنعت فناوری است که میخواهد از هوش مصنوعی بهره ببرد. گوگل اخیراً دو پژهشگر به نام تیمیت گبرو و مارگارت میچل که در زمینه اخلاق هوش مصنوعی تحقیق میکردند را تحت فشار قرارداد. آیا مشارکت صنعت، تحقیقاتی که هوش مصنوعی را زیر سوال میبرند را محدود میکند؟»

کرافورد در پاسخ به این سوال گفت: «من نمیتوانم درمورد آنچه در داخل گوگل اتفاق افتاده صحبت کنم، اما آنچه دیدهام فوق العاده نگران کننده است. مهم است که ما محققانی در داخل شرکتهای فناوری داشته باشیم که ببینند این سیستمها چگونه کار میکنند و در این باره گزارش منتشر کنند. ما ملاحظه میکنیم به جای اینکه با دید وسیعتر به چگونگی ادغام این سیستمها با نهادهای اجتماعی پیچیده و پر خطر مانند عدالت کیفری، آموزش و مراقبتهای بهداشتی پرداخته شود تحقیقات بیش از حد بر روی اصلاحات فنی و رویکردهای ریاضی سوگیری و متمرکز شده است. من بیشتر دوست دارم که تحقیقات کمتر به سوالات اخلاقی و بیشتر به جایگاه قدرت ونفوذ بپردازند. این سیستمها توسط منافع قدرتمندی استفاده میشوند که افرادی پرنفوذ و قدرتمند در پشت آن هستند.»

کرافورد در پاسخ به سوال “آیا هوش مصنوعی هنوز مفید است؟” گفت: «بیایید شفاف صحبت کنیم: پیشبینی آماری فوق العاده مفید است. صفحه گسترده اکسل نیز چنین است. اما این با منطق خاص خود، سیاست خاص خود، ایدئولوژیهای خاص خود همراه است که مردم به ندرت از آنها آگاه میشوند.» وی ادامه داد: «به سیستمهایی تکیه کردهایم که از ایمنی مورد انتظار شما به عنوان چیزی که در زندگی روزمره بسیار تأثیرگذار است، برخوردار نیستند. ما یک وضعیت اضطراری مقررات داریم: ابزارهایی در واقع باعث آسیب میشوند که کامل کنترل نشدهاند.»

کرافورد در پاسخ به سوال “آیا به زودی تغییرات را میبینیم؟” گفت: «داریم نزدیکتر میشویم ما الوندرا نلسون را در دفتر سیاست علم و فناوری کاخ سفید داریم، که در مورد این واقعیت نوشته است که شما نمیتوانید از سیاست فناوری فرار کنید. ما در حال ایجاد ائتلاف جدیدی از فعالان و محققان هستیم که میبینند رابطه متقابل سرمایهداری و محاسبات هسته اصلی عدالت اقلیمی و حقوق کار و عدالت نژادی است. من خوشبین هستم.»

منبع: wired